行人再识别综述

1、行人重识别技巧

1.1、表征学习

表征学习方法旨在根据行人外观, 学习行人的一般特征表示, 并要求对光照、姿态, 视角等变化 具有一定抗干扰能力.

利用深度网络从大量数据中学习网络参数, 并自动提取强判别力行人特征的方法逐渐成 为主流.

1.1.1、图像特征学习

行人特征表示可以分为全局特征表示和局部特征表示

局部特征辅助全局特征学习和表示在行人再识别更广泛

基于水平分块对齐:将图像均分为若干条块,以提取部件特征。比如PCB网络使用水平分块结合优化,进一步提出RPP细化分块方法以增强局部一致性。

基于姿态估计:通过姿态估计提取人体关键点,并结合局部和全局特征以更好地表示行人特征。例如,PIE描述符和GLAD通过姿态对齐和全局-局部结合实现更鲁棒的特征表示。

基于注意力机制:利用网络自适应关注行人区域,弱化背景信息的影响,如CAN和ABD-Net等方法强化了行人局部特征细节,提升识别精度。

1.1.2、视频特征学习

视频序列相比单帧图像包含更多丰富的时空信息

视频行人再识别方法的一般形式为先使用特征提取器从视频帧中提取帧组的特征, 再通过特征聚合得到视频组特征描述符.

关键之处在于如何聚合序列帧的特征

基于池化:将视频帧特征通过最大池化、时序池化等方法聚合,生成视频级表征。例如,双流卷积网络同时处理RGB图像和光流信息来捕捉运动特征。

基于循环神经网络:建模视频序列的运动信息,通过时空池化组合帧特征。典型方法包括累积运动上下文(AMOC)网络,它通过双流卷积结构融合空间和运动信息。

基于注意力机制:引入注意力模块来自动聚焦有利于再识别的时空区域,提升特征表达。方法包括时空注意池化、时空自适应网络等,用于捕捉视频序列的时空特征。

基于图模型:构建时空图结构来捕捉帧内和帧间关系,以提高特征表示的细致性和连贯性。例如,邻接图和时空图卷积网络可以细化视频帧间的特征关联性。

将 RNN 与 CNN 相结合成为一个经典方向.

由于 RNN-CNN 模型存在难以训练的问题 (如大量参数问题和梯度问题), 注意力机制替换 RNN-CNN 结构成一个主流方向

1.2、度量学习

在行人再识别任务中的度量学习通过三种损失函数来衡量图像间的相似度,这三种损失包括分类损失、验证损失和三元组损失。每种方法都采用不同的公式来优化特征距离,具体如下:

在行人再识别任务中的度量学习通过三种损失函数来衡量图像间的相似度,这三种损失包括分类损失、验证损失和三元组损失。每种方法都采用不同的公式来优化特征距离,具体如下:

1. 分类损失

分类损失将行人再识别视为一个图像分类问题,其目标是通过最大化样本真实类别的后验概率来优化样本间距。交叉熵损失是常用的分类损失,其公式为:

其中, y_i 表示样本 i 的标签, x_i 是输入样本, n 是每个批次中训练样本的数量。

该公式通过最大化真实类别的后验概率,使网络能够在特征空间中对相似样本进行聚类,进而优化不同样本之间的距离。

此类损失可以自动挖掘难分类样本,并易于与其他损失函数结合,提升模型的泛化能力。标签平滑化策略等变体进一步提升了模型的鲁棒性。

2. 验证损失

验证损失基于相似样本在特征空间中相似的假设,通过图像对的方式构建损失函数。验证损失通常采用对比损失,其基本公式如下:

\delta_{ij} 是相似度标签,若样本 i 和 j 属于同一类别,则 \delta_{ij} = 1 ,否则 \delta_{ij} = 0 。

\rho 为阈值参数,网络会更加关注不相似样本对(负对)之间的距离。

d_{ij} 表示样本 i 和 j 的嵌入特征的欧氏距离。

在该公式中,相似样本对的距离越小,不相似样本对的距离越大,从而增强特征的判别力。基于验证损失的二分类验证方法也常见于行人再识别,使用交叉熵计算如下:

其中, f_{ij} = (f_i - f_j)^2 表示样本特征间的平方差,用于判断图像对的相似度。

3. 三元组损失

三元组损失将行人再识别任务转化为一个检索排序问题,通过锚样本、正例样本和负例样本三元组的输入来优化特征距离。其公式为:

d_{a,p} 为锚样本 X_i 与正例样本 X_i^+ 的距离。

d_{a,n} 为锚样本 X_i 与负例样本 X_i^- 的距离。

\alpha 是预定义的距离阈值。

该公式要求正样本对的距离小于负样本对的距离加上阈值,从而推动相同类别样本聚集,同时使不同类别样本分离。改进的困难挖掘中心三元组损失(HCT)进一步优化类内和类间距离,其公式为:

c_p 是第 p 类的深度特征中心。

f_i^p 是第 p 类中第 i 样本的深度特征。

d(c_p, f_j^l) 是特征中心与负例样本的距离。

1.3、 重排序优化

在行人再识别中,重排序用于进一步提升检索精度。通过候选集上下文信息和相似度信息优化初始排序,方法包括基于用户反馈、流形结构和近邻信息挖掘。例如,双向排名算法通过从内容和上下文计算图像相似性,获取更准确的排序结果。

2、开放行人再识别

遮挡行人再识别主要研究如何在行人部分信息被遮挡的情况下,提取有效特征并合理度量相似性。研究重点集中在以下两个方面:

1、遮挡行人再识别

1. 非遮挡特征表示学习

这一方向旨在减弱遮挡噪声影响,获取遮挡行人的有效特征描述。主要方法包括:

身体注意力机制:Zhuo 等人通过遮挡模拟器生成遮挡样本,并用多任务损失训练网络,提升遮挡行人的特征学习能力。

姿态引导对齐:Miao 等人利用姿态信息引导网络提取人体关键区域特征,并提供了 Occluded-DukeMTMC 数据集以支持研究。

金字塔特征:He 等人提出金字塔重建法 (FPR),使用空间金字塔特征增强遮挡行人的相似性度量。

局部可见性预测:Yoo 等人通过姿态估计定位可见区域,细化特征描述,改善遮挡行人特征的鉴别力。

增量式遮挡生成:Zhao 等人提出 IGOAS 网络,生成从易到难的遮挡数据,并通过对抗分支抑制生成的遮挡区域。

2. 有效对齐和度量

针对遮挡区域差异性,研究如何实现特征间的对齐与度量。方法包括:

局部-全局特征匹配:Zheng 等人提出结合局部-局部和全局-局部特征匹配的框架,提升遮挡行人间的相似性度量。

深度空间特征重构:He 等人提出 DSR 方法,通过字典学习的重构误差计算遮挡图像的空间特征相似性。

可见性感知模型:Sun 等人提出基于半监督学习的 VPM 模型,判断遮挡区域并实现不同遮挡行人间的自适应对齐。

遮挡增强与掩码网络:Chen 等人提出遮挡增强方法,通过生成多样化遮挡数据,设计遮挡感知掩码网络,利用注意力机制获取未遮挡区域。

目前遮挡行人再识别方法在性能上与实际应用需求尚有差距,未来研究仍需提升模型的遮挡鲁棒性和实际应用效果。

2、无监督行人再识别

无监督域适应:这种方法依赖源域(带标签数据集)和目标域(无标签数据集)之间的域迁移。为减少源域与目标域的差异,许多研究采用对抗生成网络(GAN)进行图像迁移。例如,CycleGAN等模型实现源域和目标域图像风格的迁移,保持行人外观信息不变,使目标域图像更适应源域模型。此外,还有基于特征空间对齐的方法,通过学习将源域和目标域图像映射到一个共享特征空间,减少分布差异。另有研究在目标域内进行细粒度风格迁移,在相机间保持身份一致性,提高模型泛化能力。

目标域数据结构挖掘:这类方法利用目标域图像的无标签数据,通过聚类、度量学习等手段挖掘内部结构。例如,使用K-means聚类等方法生成伪标签,再利用伪标签训练分类网络,以迭代方式不断优化特征。其他研究利用相机内外信息分阶段计算样本相似度,逐步找到可靠的伪标签。此外,利用辅助任务(如人体解析)为行人图像定位特征,增强模型的泛化能力。

3、半监督行人再识别

区域度量学习:利用标签传播估计正邻居,通过邻居集生成区域,增强未标记数据的判别能力。

图模型和伪标签:通过图模型挖掘无标签数据的关系,或使用伪标签生成方法(如LSRO)为无标签样本提供统一标签分布,改进模型学习。

单样本学习:在只有一个轨迹有标签的情况下,采用动态图匹配和逐步伪标签选择等方法,使伪标签在训练中逐渐可靠。

4、跨模态行人再识别

图像-视频行人再识别:用于从图像中快速查找视频中的相应目标。方法包括联合特征投影矩阵和异构字典、LSTM网络对视频时序信息的编码、以及时域知识传播来缓解图像与视频信息的不对称性。

文本-图像行人再识别:利用文字描述匹配图像,适用于获取图像困难的场景。常采用双塔模型提取文本和图像特征,并进行细粒度对齐和模态对齐,以实现高精度匹配。基于 Transformer 架构, 将行人按照语义划分, 以匹配具有视觉-语言共同注意的区域

可见光-红外行人再识别:

提取共享特征:利用双输入网络或生成对抗网络(GAN)提取RGB和红外图像的共享特征,结合注意力机制和跨模态损失,增强模态间一致性。

结合RGB与红外特征:通过CycleGAN实现模态转换或利用特异特征变换算法,使RGB图像和红外图像结合以减少模态差异。还通过集合级和实例级对齐来优化跨模态特征匹配。

X模态辅助:引入中间模态(X模态)作为RGB和红外之间的过渡,结合神经特征搜索(NFS)自动优化特征选择,提升模态对齐效果。

由于标注成本高,一些方法采用无监督跨模态学习,以伪标签和自模态重排序策略提升跨模态性能。可见光-红外行人再识别在低光环境下应用潜力巨大,能有效缓解模态差异问题。

5、场景行人搜索

端到端行人搜索:将检测和识别联合在一个网络中,以提高检测和识别的一体化效果。典型方法包括基于Faster-RCNN的OIM模型、孪生网络辅助查询以及图卷积网络(GCN)等。尽管性能较高,但计算开销大,一些无锚框模型(如AlignPS)被提出以提升效率。

两阶段行人搜索:将检测和识别分开进行,避免两者优化冲突。检测聚焦于行人共性,识别则关注差异性。例如,通过独立的CNN流获取特征,或在检测网络与识别网络间加入ROI转换器以增强识别精度。这种方式在实时性和精度上更具优势。

6、对抗鲁棒行人再识别

度量攻击:Bai等首次提出对抗性度量攻击,通过破坏行人再识别系统的距离度量生成对抗样本,使模型误判相似性。

通用对抗扰动:Ding等提出通用扰动方法和跨模型攻击机制,提升了对抗扰动在不同模型上的攻击效果,适应开放集设定。

开放集攻击:Yang等提出基于虚拟引导的攻击算法,Gong等研究开放集的黑盒攻击,揭示了开放集模型同样易受到对抗攻击。

7、快速检索——哈希行人再识别

基于传统哈希:通过子空间映射和二进制编码策略,将图像特征映射到汉明空间以解决跨视角问题,例如跨视角二值身份(CBI)和跨相机语义二值化(CSBT)方法。

基于深度哈希:在网络末端加入哈希层生成二值编码,通过显著性引导、自蒸馏和对抗学习等方式提升编码质量和匹配效率,如比特扩展深度哈希(DRSCH)和对抗性二进制转换(ABC)。

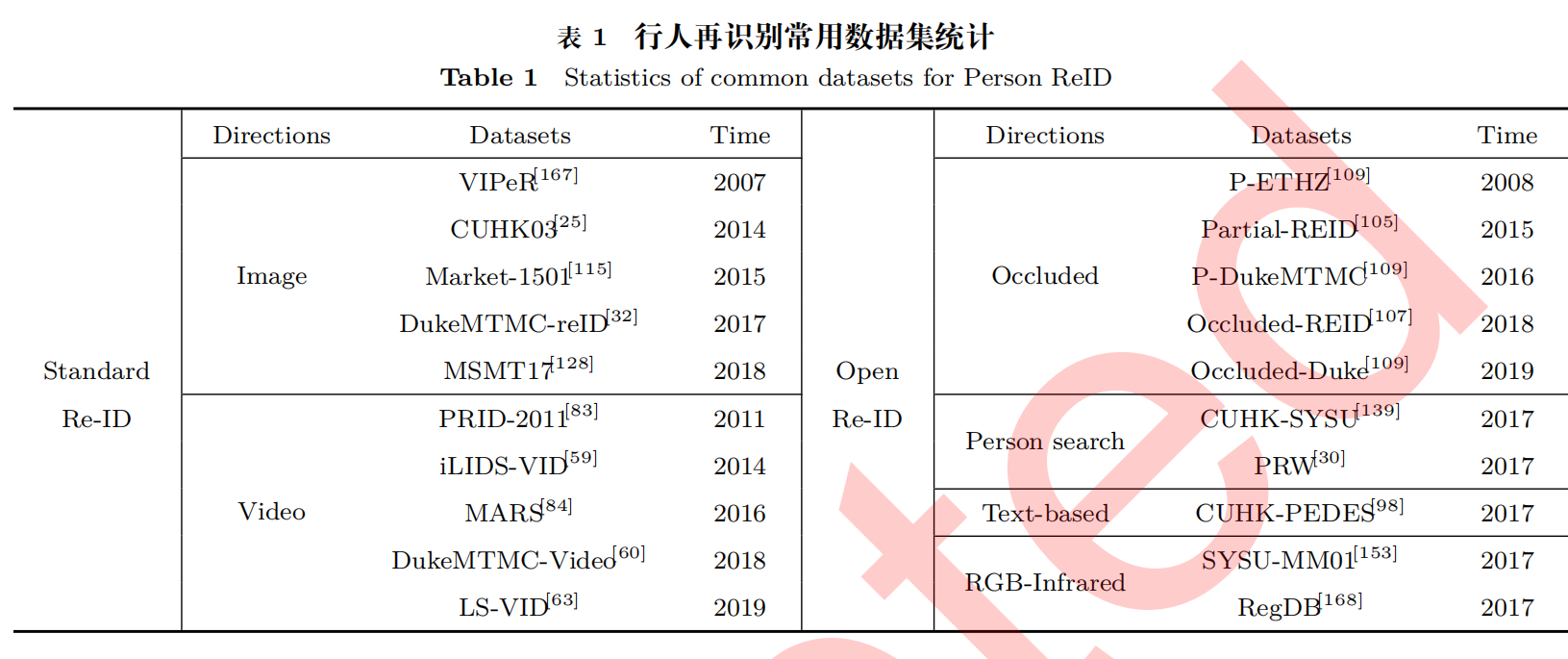

3、数据集

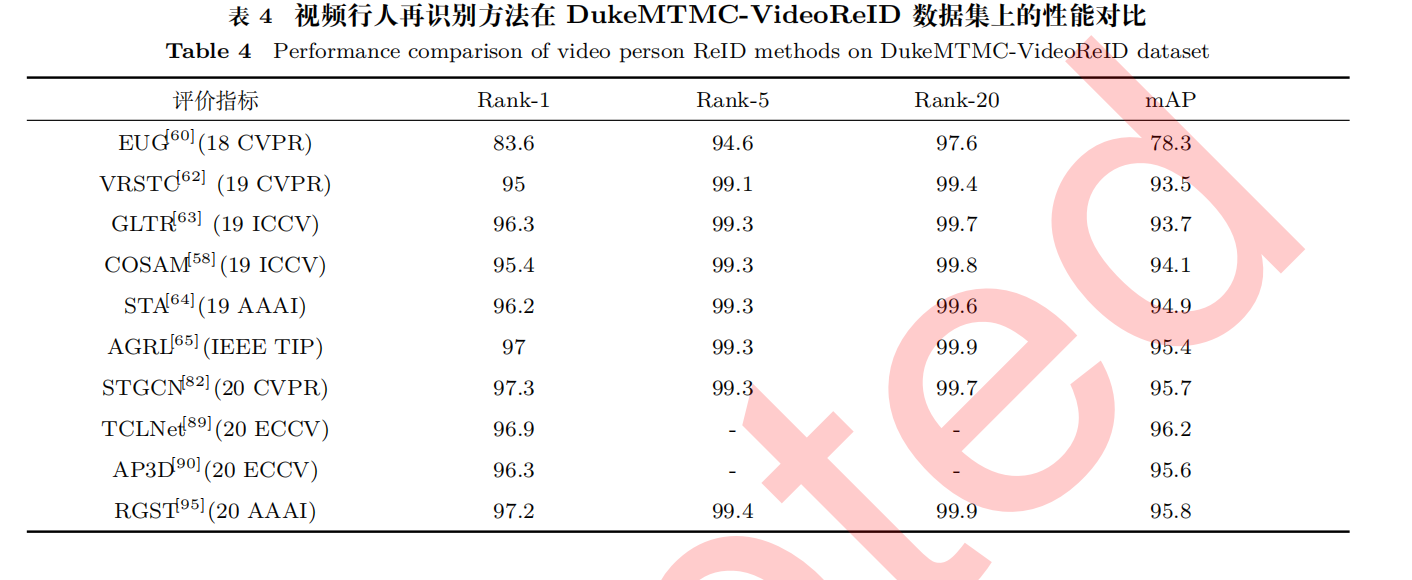

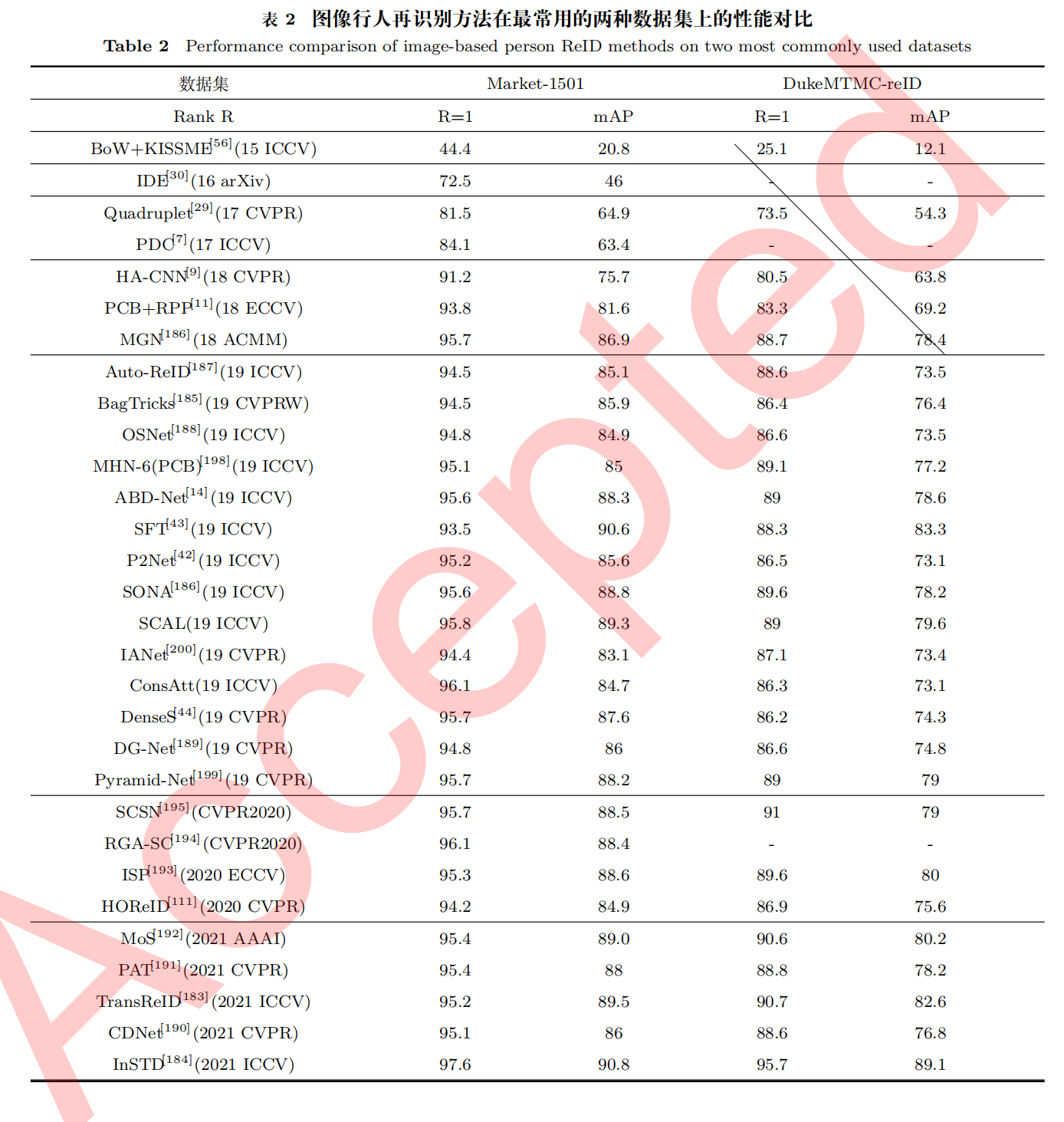

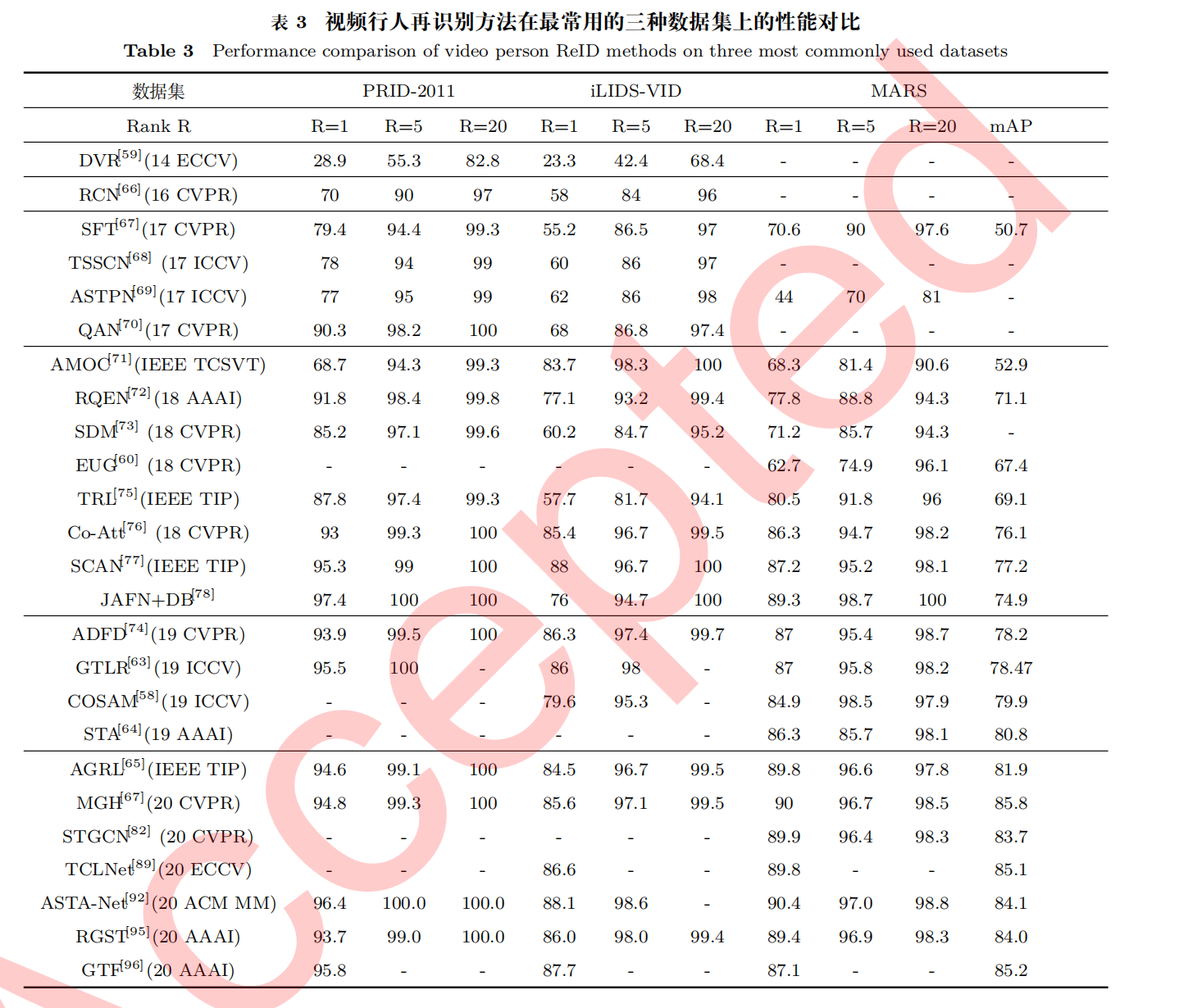

4、模型对比

5、未来展望

完整行人再识别系统:集成行人检测、追踪和识别,实现从监控视频中的目标定位到识别的完整流程。

隐私与安全:在确保视频监控功能的前提下,如何去除个人身份信息,以维护隐私安全。

开放问题集成:应对复杂监控环境中的多重问题,如光照、遮挡和背景干扰,将各类应对方法集成到统一模型中。

多源信息融合:将红外、深度图像和文本信息等多模态数据结合,提升行人识别的可靠性。

半监督与无监督学习:发展无标签或少量标签数据下的识别方法,降低人工标注成本,提升实际应用性。

视觉Transformer:借助Transformer的全局建模能力,进一步改善对复杂图像信息的处理,但仍需克服其高计算开销等问题。